原文連結: NVIDIA CEO Jensen Huang Keynote at COMPUTEX 2025

開場與NVIDIA的台灣淵源

歡迎 Nvidia 創辦人暨執行長 Jensen Huang 登台。能來到這裡真是太棒了。我的父母也在觀眾席。他們在那裡。Nvidia 來台灣已經超過 30 年了。這裡是我們許多珍貴合作夥伴和摯友的家。多年來,你們見證了 Nvidia 的成長,看到我們完成了許多令人興奮的事情,並且一路以來都與我並肩合作。今天,我們將討論我們在產業中所處的位置、我們將走向何方、宣布一些新產品、令人興奮的新產品和令人驚訝的產品,這些產品為我們開闢了新市場、創造了新市場、帶來了新的增長。

我們將討論偉大的合作夥伴以及我們將如何共同發展這個生態系統。如你們所知,我們處於電腦生態系統的中心,這是世界上最重要的產業之一。

因此,理所當然地,當新市場必須被創造時,我們必須從這裡開始,在電腦生態系統的中心。我為你們準備了一些驚喜,一些你們可能猜不到的事情。然後當然,我保證我會談論 AI,我們也會談論機器人學。

NVIDIA的革新之路

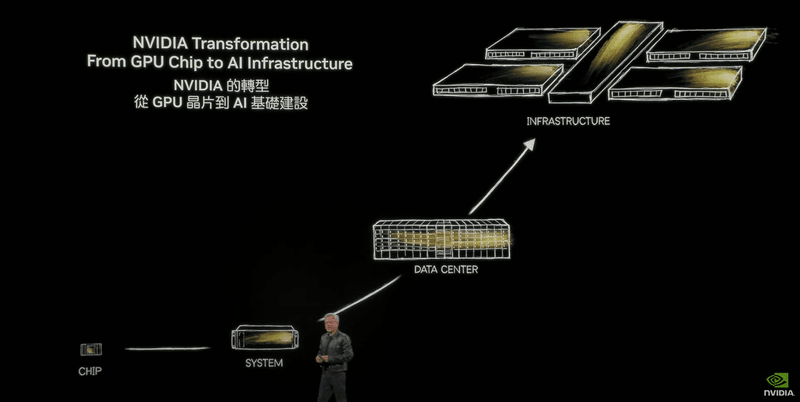

NVIDIA 的故事是電腦產業的革新。事實上,NVIDIA 的故事也是我們公司的革新。

正如我所說,我來這裡已經 30 年了。你們中的許多人經歷過我的許多主題演講。有些人,甚至全部都經歷過。回顧我們在過去 30 年中談論的對話和事物,我們改變得有多麼巨大。我們最初是一家晶片公司,目標是創建一個新的運算平台,並在 2006 年推出了 CUDA,它徹底改變了運算的完成方式。

2016 年,也就是 10 年後,我們意識到一種新的運算方法已經到來。而這種新的運算方法需要對技術堆疊的每一層進行革新。處理器是新的,軟體堆疊是新的。理所當然地,系統也是新的。因此,我們發明了一個新系統。一個在我於 GTC 2006 宣布它時,沒有人明白我在說什麼,也沒有人給我採購訂單的系統。

那個系統叫做 DGX1。DGX1。我把第一個捐給了一家名為 OpenAI 的非營利公司,它開啟了 AI 革命。多年後,我們意識到,事實上,這種新的軟體運作方式,現在稱為人工智慧,與傳統的軟體運作方式不同。過去許多應用程式在大型資料中心內的少數處理器上運行,我們稱之為超大規模(hyperscale)。

這種新型應用程式需要許多處理器協同工作,為數百萬人提供查詢服務,而該資料中心的架構將有根本性的不同。我們意識到有兩種網路類型。一種是南北向的,因為你仍然需要控制儲存。你仍然需要一個控制平面。

你仍然需要連接到外部。但最重要的網路將是東西向的。電腦之間互相通訊以嘗試解決問題。我們認識到在高效能運算、大規模分散式處理的東西向流量方面,最優秀的網路公司。

一家與我們公司非常親近、與我們心靈相通的公司,叫做 Mellanox。我們在五年前,也就是 2019 年收購了他們。我們將整個資料中心轉換成一個運算單元。你們以前聽我說過,現代電腦就是一個完整的資料中心。資料中心是一個運算單元。

不再只是一台個人電腦,不再只是一台伺服器。整個資料中心都在運行一個任務,作業系統也會改變。

NVIDIA作為AI基礎設施公司

Nvidia 的資料中心之旅現在非常有名。在過去三年中,你們已經看到我們正在塑造的一些想法,以及我們如何開始以不同的方式看待我們的公司。

歷史上沒有一家公司,當然也沒有一家科技公司,曾經一次揭露長達五年的路線圖。沒有人會告訴你接下來會發生什麼。他們會將其視為秘密,極度機密。然而,我們意識到 Nvidia 不再僅僅是一家科技公司。事實上,我們是一家至關重要的基礎設施公司。

你如何規劃你的基礎設施、你的土地、你的廠房、你的電力、你的電力供應,以及全球所有必要的融資?如果你不了解我將要製造什麼,你怎麼可能做到這點?因此,我們相當詳細地描述了我們公司的路線圖。細節程度足以讓全世界的每個人都可以開始建造資料中心。

我們現在意識到我們是一家 AI 基礎設施公司。一家對全球各地都至關重要的基礎設施公司。每個地區、每個產業、每個公司都將建立這些基礎設施。這些基礎設施是什麼?這些基礎設施事實上與第一次工業革命時人們意識到 GE、Westinghouse、Siemens 發現了一種名為電力的新技術,並且必須在世界各地建立新的基礎設施,而這些基礎設施成為社會基礎設施的重要組成部分,那種基礎設施現在被稱為電力。多年後,這是在我們這一代人的時期,我們意識到出現了一種新型基礎設施。這種新基礎設施非常概念化,很難理解。這種基礎設施稱為資訊。這種資訊基礎設施第一次被描述時,沒有人能理解。

但我們現在意識到它就是網際網路。網際網路無所不在,萬物都與之相連。嗯,現在有了一種新的基礎設施。這種新的基礎設施建立在前兩者之上。而這種新的基礎設施是一種智慧的基礎設施。我知道現在當我們說有智慧基礎設施時,這聽起來毫無道理。

但我向你保證,十年後,你會回顧並意識到 AI 已經融入一切。事實上,我們到處都需要 AI,每個地區、每個產業、每個國家、每個公司都需要 AI。AI 現在已成為基礎設施的一部分。而這個基礎設施就像網際網路、就像電力一樣,需要工廠。

AI工廠的崛起

這些工廠基本上就是我們今天建造的。它們不是過去的資料中心。一個價值一兆美元的產業,提供資訊和儲存,支援我們所有的 ERP 系統和我們的員工。那是過去的資料中心。這種類似之處在於它來自同一個產業。

它來自我們所有人,但它將演變成完全不同的東西,完全與世界的資料中心分離。而這些 AI 資料中心,如果你願意這樣稱呼它們,其實描述得並不恰當。它們實際上是 AI 工廠。你投入能源,它就會產生非常有價值的東西。這些東西被稱為詞元(tokens),以至於公司開始談論他們上一季產生了多少詞元,上個月產生了多少詞元。

很快我們就會談論我們每小時產生多少詞元,就像每個工廠一樣。所以世界已經發生了根本性的變化。我們從一家公司開始,在我們創立公司的那天。我在 1993 年試圖弄清楚我們的機會有多大,我得出的結論是 Nvidia 的商業機會是巨大的。

三億美元。我們要發財了。從三億美元的晶片產業,到一個約值一兆美元的資料中心機會,再到現在一個將以數兆美元計的 AI 工廠和 AI 基礎設施產業。這就是我們正在開創的激動人心的未來。

NVIDIA的核心技術:加速運算、AI與CUDA X函式庫

現在,我們所做的一切,其核心都建立在幾項重要技術之上。

當然,我經常談論加速運算。我經常談論 AI。讓 Nvidia 與眾不同的是這些能力的融合,尤其特別的是演算法、函式庫,我們稱之為 CUDA X 函式庫。我們一直在談論函式庫。

事實上,我們是世界上唯一一家不停談論函式庫的科技公司。原因在於函式庫是我們所做一切的核心。函式庫是一切的開端。今天我將向你們展示一些新的函式庫。但在我這麼做之前,讓我先給你們預告一下我今天要講的內容。

你即將看到的一切,你即將看到的一切都是模擬、科學和人工智慧。你看到的沒有一樣是藝術。全都是模擬。只是碰巧很美。讓我們看看。

GeForce與AI在繪圖領域的革新

這是我面前的即時電腦繪圖。這不是影片。這是由 GeForce 產生的電腦繪圖。這是全新的 GeForce 5060 RTX 5060。而這個,這個是 Asus 的。我的好朋友 Johnny 在前排。而這個,這個是 MSI 的。我們把這個令人難以置信的 GPU 縮小放進這裡。

這合理嗎?看,這太不可思議了。所以,這個,這是 MSI 的新款筆記型電腦,裡面有 5060。GeForce 將 CUDA 帶給了世界。現在,你所看到的是每個像素都經過光線追蹤。我們怎麼可能模擬光子並以這種解析度提供這樣的影格率呢?嗯,原因就是人工智慧。

我們只渲染了十分之一的像素。所以你看到的每個像素,實際上只有十分之一是被計算出來的。其他九個是 AI 猜出來的。這樣說得通嗎?而且它完美無瑕。完全完美。它猜得完美無缺。當然,這項技術叫做 DLSS,神經渲染。

我們花了很多很多年才開發出來。我們從開始研究 AI 的那一刻起就開始開發它了。所以這是一段長達十年的旅程。而電腦繪圖的進步已經被 AI 徹底革新了。GeForce 把 AI 帶給了世界。現在 AI 回過頭來革新了 GeForce。所以,真的,真的很了不起。

各位先生女士,GeForce,你知道,當你是 CEO 時,你有很多孩子。而 GeForce 把我們帶到這裡。現在我們所有的主題演講 90% 都不是 GeForce。但這不是因為我們不愛 GeForce。GeForce RTX 50 系列剛剛經歷了有史以來最成功的發布,是我們歷史上最快的發布,而 PC 遊戲現在已經有 30 年的歷史了。

所以這告訴你 GeForce 有多麼不可思議。

CUDA X函式庫的廣泛應用

讓我們來談談函式庫。當然,一切的核心都始於 CUDA。透過讓 CUDA 盡可能高效能、盡可能普及,以便全球各地都有安裝基礎,那麼應用程式就能輕易找到 CUDA GPU。

安裝基礎越大,就有越多的開發者想要創建函式庫。函式庫越多,就能完成越多令人驚奇的事情,應用程式就越好,使用者就能獲得更多益處。他們會購買更多的電腦。電腦越多,CUDA 就越多。這個回饋路徑至關重要。然而,加速運算並非通用運算。

通用運算撰寫軟體。每個人都用 Python、C 或 C++ 來寫,然後進行編譯。通用運算的方法論始終如一。撰寫應用程式、編譯應用程式、在 CPU 上執行它。然而,這在加速運算中根本行不通,因為如果可以這樣做,那它就會被稱為 CPU。

不改變 CPU 的意義何在?所以,你可以編寫軟體、編譯軟體、在 CPU 上運行。事實上,你必須做一些不同的事情,這其實是很合理的。原因在於有這麼多人致力於通用運算,投入了數兆美元的創新。

怎麼可能突然之間,晶片裡的一些小元件,電腦就變快了 50 倍、100 倍?這說不通。所以我們應用的邏輯是,如果你對應用程式了解更多,你就可以加速它。如果你創建一個更適合加速的架構,以光速運行 99% 的執行時間,即使它只佔程式碼的 5%,這相當令人驚訝,大多數應用程式中,一小部分程式碼會消耗大部分的執行時間,你就可以加速應用程式。

我們觀察到這一點,所以我們一個接一個地攻克各個領域。我剛才向你們展示了電腦繪圖。我們還有數值計算。這是 Koopai numeric。這是,Koopai 是最普及的數值函式庫。Aerial 和 Shona。

Aerial 是世界上第一個用於 5G 和 6G 的 GPU 加速無線電訊號處理。一旦我們將其軟體定義化,我們就可以在其之上加入 AI。所以現在我們可以將 AI 引入 5G 和 6G。用于基因組分析的 Pars。用於醫學影像的 Monai。用於天氣預測的 Earth 2。用於量子經典電腦架構和電腦系統的 Coup quantum。

CU equariance 和 CU tensor contraction of tensor mathematics。這一整列,這一整列包含了我們所有的深度學習以及所有訓練和推論深度學習所需的函式庫。它徹底革新了運算,而這一切都始於所有這些函式庫,不僅僅是 CUDA,還有 KUDDNN,在 KUDDNN 之上是 Megatron,Megatron 之後是 Tensor RTLM,然後是現在最新的這個用於大型 AI 工廠的全新作業系統 Dynamo QDF,用於像 Spark 和 SQL 這樣的資料框,結構化資料也可以加速。QML 古典機器學習,Warp 一個用於描述 CUDA 核心的 Pythonic 框架,非常成功。Coup 數學運算優化,例如旅行推銷員問題,能夠優化高度受限、變數眾多類型的問題,如供應鏈優化,這是一個令人難以置信的成功。

我對 co-opt、Coup DSS 和 Coup sparse 用於稀疏結構模擬器感到非常興奮,這些模擬器用於 CAE 和 CAD 流體動力學、有限元素分析對於 EDA 和 CAE 產業來說極其重要,然後當然是 KU litho,這是計算光刻最重要的函式庫之一。光罩製作很容易就需要一個月的時間,而光罩製作過程的計算量極其龐大,現在有了 KU litho,我們可以將計算速度加快 50 倍、70 倍,因此,這將為未來將 AI 應用於光刻技術奠定基礎,開闢了新的天地。

我們在這裡有很棒的合作夥伴。TSMC 正在廣泛使用 KU Litho。ASML、Synopsis 是我們在 Kitho 方面的優秀合作夥伴。所以,這些函式庫本身使得我們能夠一個接一個地應用領域、一個接一個地科學領域、一個接一個地物理領域加速這些應用程式。

NVIDIA拓展新市場:電信與量子運算

但它也為我們開闢了市場。我們關注特定的地區和特定的市場,我們認為那個領域對於轉型到新的運算方式可能非常重要。如果通用運算在這麼多年後已經走到盡頭,為什麼它沒有在每個行業都走到盡頭呢?當然,最重要的行業之一是電信。

正如全球的雲端資料中心現在已經實現軟體定義一樣,電信業也理應實現軟體定義。這就是為什麼我們花了大約六年的時間來完善和優化一個完全加速的無線電接入網路(RAN)堆疊,它在每瓦特數據傳輸率或每瓦特數據速率方面具有令人難以置信的性能。

我們現在已經與最先進的 AS6 並駕齊驅。因此,一旦我們能夠做到這一點,一旦我們能夠達到那種性能和功能水平,之後我們就可以在其上疊加 AI。所以我們在這裡有很棒的合作夥伴。你可以看到 SoftBank 和 T-Mobile、Indoad 和 Vodafone 正在進行試驗。Nokia、Samsung、Kyocera 正在與我們合作開發完整的堆疊。

Fujitsu 和 Cisco 正在開發系統。因此,現在我們有能力將 AI on 5G 或 AI on 6G 的概念,以及 AI on computing 一起引入。我們正在透過量子運算來實現這一點。量子運算仍處於嘈雜的中等規模量子(NISK)階段。然而,我們已經可以開始做許多好的應用,所以我們對此感到興奮。

我們正在開發一個量子經典或量子 GPU 運算平台。我們稱之為 CUDAQ,與全球眾多傑出公司合作。GPU 可用於預處理和後處理、錯誤校正以及控制。因此,我預測未來所有超級電腦都將配備量子加速器。

所有都將連接量子 QPU。因此,一台超級電腦將是一個帶有 QPU、GPU 和一些 CPU 的 QPU。這將是現代電腦的代表。因此,我們正在與該領域的許多優秀公司合作。

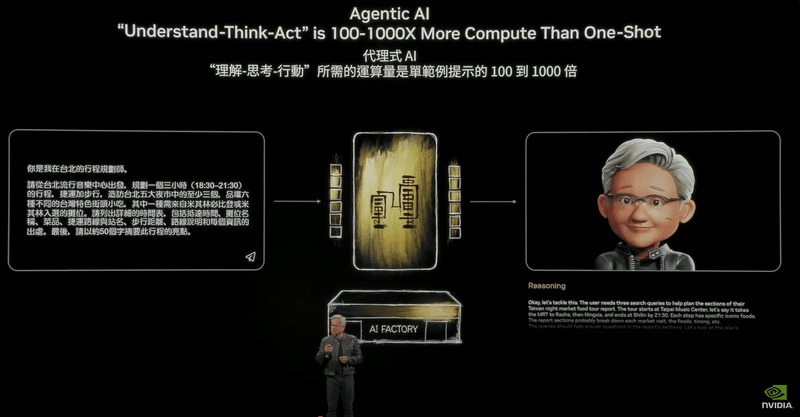

AI的演進:從感知到生成、代理式與物理AI

12 年前,我們從感知 AI 模型開始,這些模型可以理解模式、識別語音、識別圖像。那是開端。

過去五年,我們一直在談論生成式 AI,也就是 AI 不僅能理解,還能生成的能力。所以,它可以從文本生成文本。我們在 chatbt 中一直使用它。文本到圖像、文本到影片、影片到文本、圖像到文本,幾乎任何東西到任何東西。這就是我們發現的 AI 真正令人驚奇的地方,一個通用的函數逼近器,一個通用的翻譯器。

它可以將任何東西翻譯成任何其他東西,只要我們能將其符號化,表示資訊的位元。嗯,現在我們已經達到了 AI 一個非常重要的水平。生成式 AI 給了我們一次性 AI。你給它一段文字,它就給你一段文字回來。那是兩年前我們第一次接觸 Chat GPT 時的情景。

那是一個巨大的驚人突破。你給一段文字,它就給你一段文字回來。它預測下一個詞,預測下一個段落。然而,智慧遠不止於你從大量學習過的資料中所學到的東西。智慧包括推理能力,能夠解決你以前從未見過的問題,一步一步地分解它,也許應用一些規則和定理來解決你從未見過的問題。

能夠模擬多個選項並權衡其益處。你可能聽說過的一些技術,如思維鏈(chain of thought),逐步分解;思維樹(tree of thought),提出一大堆路徑,所有這些技術都引領著 AI 具備推理能力。

現在,令人驚奇的是,一旦你擁有了推理能力和感知能力,也就是說,多模態閱讀 PDF,你可以進行搜索,你可以使用工具,你就擁有了代理式 AI(agentic AI)。這個代理式 AI 做的正是我我剛剛描述了我們所有人都在做的事情。我們接受一個目標。我們一步一步地分解它。我們思考該做什麼,最好的方法是什麼。我們考慮其後果,然後開始執行計畫。計畫可能包括做一些研究,可能包括使用一些工具做一些工作。

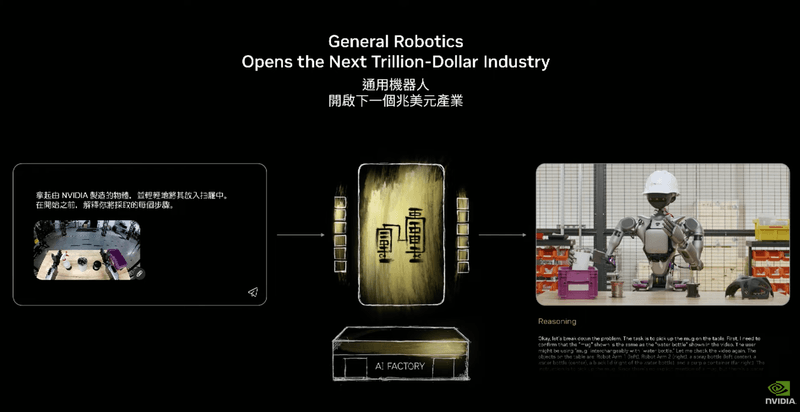

它可能包括聯繫另一個 AI 代理與之協作。代理式 AI 基本上就是理解、思考和行動。嗯,理解、思考和行動就是機器人循環。代理式 AI 基本上就是數位形式的機器人。這些在未來幾年將會非常重要。我們在這個領域看到了巨大的進展。

接下來的浪潮是物理 AI。理解世界的 AI。它們理解慣性、摩擦力、因果關係等概念。如果我滾動一個球,它滾到汽車底下,根據球的速度,它可能滾到了汽車的另一邊,但球並沒有消失。物體恆存性。

你或許能夠推斷,如果你面前有一張桌子,而你必須走到另一邊。最好的方法不是直接穿過去。最好的方法也許是繞過去或從底下過去。能夠對這些物理事物進行推理,對於 AI 的下一個時代至關重要。我們稱之為物理 AI。

所以在這個特定的例子中,你看到我們只是提示 AI,它就會生成影片來訓練自動駕駛汽車在不同場景下的應對。稍後我會展示更多。那是一隻狗。它是一個生成模型,有鳥,有人。它從左邊的圖像開始。

然後,在那之後的階段,我們採用推理系統、生成系統、物理 AI,而這種能力水平現在將進入一個物理實體。我們稱之為機器人。如果你能想像你可以提示 AI 生成一個影片來伸手拿起一個瓶子。當然,你也可以想像告訴一個機器人伸出手拿起那個瓶子。

今日的 AI 能力已經具備做這些事情的能力。嗯,我們正在建造的電腦,那就是我們在不久的將來要達成的目標。我們正在建造的電腦,使其成為可能,具有與以往非常不同的特性。

Grace Blackwell:新一代AI超級電腦

革命性的電腦 Hopper 大約三年前問世,它徹底改變了我們所知的 AI。

它可能成為世界上最受歡迎、最知知名的電腦。在過去幾年中,我們一直在開發一款新電腦,以便我們能夠進行推論時間擴展,或者基本上是極快地思考,因為當你思考時,你腦中會產生大量的詞元(tokens)。

在你產生答案之前,你會產生大量的想法並在腦中迭代。所以過去的一次性 AI 現在將變成思考型 AI、推理型 AI、推論時間擴展型 AI,而這將需要更多的運算。因此我們創造了一個名為 Grace Blackwell 的新系統。Grace Blackwell 做了幾件事情。

它具有向上擴展(scale up)的能力。向上擴展是指將一台電腦變成一台巨型電腦。向外擴展(scale out)是指將一台電腦與許多其他電腦連接起來,讓工作在許多不同的電腦上完成。向外擴展很容易。向上擴展則極其困難。建造超出半導體物理極限的大型電腦是極其困難的。 這就是 Grace Blackwell 所做的。Grace Blackwell 打破了幾乎所有的一切。而在座的各位,你們中的許多人正與我們合作打造 Grace Blackwell 系統。我很高興地說,我們已經全面投產,但我也必須說,這極具挑戰性。

儘管基於 HGX 的 Blackwell 系統自去年底以來已全面投產,並自二月份開始供貨,但我們現在才剛將所有優秀的 Grace Blackwell 系統上線。它們每天都在各地陸續上線。數週前已在 CoreWeave 上提供。

它已經被許多雲端服務供應商(CSP)使用,現在你開始看到它從各處湧現。每個人都開始在推特上發文說 Grace Blackwell 已經投入生產。今年第三季,正如我所承諾的,每年我們都會提升我們平台的效能,每年都像節奏一樣。

今年第三季,我們將升級至 Grace Blackwell GB300。GB300 將提升,它是相同的架構、相同的實體尺寸、相同的機電規格,但內部的晶片已經升級。它升級了新的 Blackwell 晶片,現在推論效能提升了 1.5 倍,HBM 記憶體增加了 1.5 倍,網路頻寬增加了 2 倍。

所以整體系統效能更高。好了,讓我們看看 Grace Blackwell 裡面有什麼。Grace Blackwell 從這個運算節點開始。這個運算節點就在這裡。這是其中一個運算節點。這是上一代的樣子,B200。

這就是 B300 的樣子。請注意中間這裡,現在是 100% 液冷。但除此之外,外觀是一樣的。你可以將它插入相同的系統和相同的機箱中。所以這就是 Grace Blackwell GB300 系統。它的推論效能提升了 1.5 倍。訓練效能大致相同,但推論效能提升了 1.5 倍。

現在這個特定的系統是 40 petaflops,這大約是 2018 年 Sierra 超級電腦的效能。Sierra 超級電腦有 18,000 個 Volta GPU。這裡的這一個節點就取代了整個超級電腦。六年間效能提升了 4,000 倍。這就是極致的摩爾定律。

記住,我之前說過 AI,Nvidia 每 10 年將運算能力擴展約一百萬倍,我們仍在朝著這個目標前進。但要做到這一點,不僅僅是讓晶片更快。晶片能做得多快、多大都是有限制的。以 Blackwell 為例,我們甚至將兩個晶片連接在一起才得以實現。

TSMC 與我們合作發明了一種名為 CoWoS-L 的新型 CoWoS 製程,使我們能夠製造這些巨型晶片。但我們仍然想要比這更大的晶片。因此,我們必須創造所謂的 MVLink。這是世界上最快的交換器。這裡的這個 MVLink,每秒 7.2 兆位元組(terabytes)。

九個這樣的裝置裝進那個機櫃。而那九個交換器是由這個奇蹟連接起來的。這個……相當重。那是因為我相當強壯。我讓它看起來很輕,但這幾乎有 70 磅。所以這是 Envy Link 主幹(spine)。兩英里的纜線,5000 條結構化纜線,都是同軸電纜,阻抗匹配,它將所有 72 個 GPU 連接到這個名為 MVLink 交換器的網路上,再連接到所有其他 72 個 GPU。

MVLink 主幹的頻寬達到每秒 130 TB。所以,讓我們比較一下,整個網際網路的尖峰流量是每秒 900 Tb。除以八。這個傳輸的流量比整個網際網路還多。一個 MVLink 主幹橫跨這九個 MVLink 交換器,因此每個 GPU 都可以同時與其他所有 GPU 通訊。

這就是 GB200 的奇蹟,而且由於 SerDes 的傳輸距離有限。這是 SerDes 有史以來從晶片傳輸最遠的距離。它從晶片到交換器,再到主幹,再到任何其他交換器,任何其他晶片,全部是電氣連接。因此,這個限制導致我們將所有東西都放在一個機櫃裡。

那個機架是 120 千瓦,這就是為什麼所有東西都必須液冷。我們現在有能力將 GPU 從一個主機板上分離出來,基本上是分散到整個機架上。所以整個機架就是一個主機板。這就是完全分離的奇蹟。現在 GPU 的效能令人難以置信。

記憶體容量令人難以置信。網路頻寬令人難以置信。現在我們可以真正地擴展它們。一旦我們向上擴展,我們就可以將它們向外擴展到大型系統中。請注意,Nvidia 製造的幾乎所有東西都非常巨大。原因在於我們不是在建造資料中心和伺服器。

我們正在建造 AI 工廠。這是 CoreWeave。這是 Oracle Cloud。每個機架的功率密度如此之高。他們不得不將它們分得更開,以便功率密度可以分散。但最終,我們不是在建造資料中心。我們是在建造 AI 工廠。

這是 XAI Colossus 工廠。這是 Stargate。400 萬平方英尺。400 萬平方英尺。1 GW。所以想想這個工廠。這個 1 GW 的工廠,這個 1 GW 的工廠可能價值,你知道的,600 到 800 億美元。在這 600 到 800 億美元中,電子設備、運算部分,這些系統就佔了 400 到 500 億美元。

所以這些都是巨大的工廠投資。人們建造工廠的原因是因為你知道答案。你買得越多。跟我一起說。你買得越多,你賺得越多。這就是工廠的作用。好的。

Blackwell的工程奇蹟

這項技術太複雜了。這項技術太複雜了。事實上,光看這裡,你仍然無法深刻體會到我們所有合作夥伴以及在座台灣所有公司所做的驚人工作。

所以我們為你製作了一部影片。我為你製作了一部影片。看看吧。Blackwell 是一個工程奇蹟。它始於 TSMC 的一塊空白矽晶圓。數百個晶片處理和紫外線光刻步驟,在 12 英寸晶圓上一層一層地構建出 2000 億個電晶體中的每一個。晶圓被切割成單獨的 Blackwell 晶粒,進行測試和分類,將優良的晶粒分離出來繼續前進。

在 TSMC spill 和 amp core 完成的晶片晶圓基板製程。將 32 個 Blackwell 晶粒和 128 個 HBM 堆疊連接到一個客製化的矽中介層晶圓上。金屬互連走線直接蝕刻到其中,將 Blackwell GPU 和 HBM 堆疊連接到每個系統和封裝單元中,將所有東西鎖定到位。然後組件進行烘烤、模製和固化,創造出 Blackwell B200 超級晶片。

在 KYC,每個 Blackwell 都在 125°C 的烤箱中進行數小時的壓力測試並推向極限。回到 Foxconn,機器人全天候工作,將超過 10,000 個組件挑選並放置到 Grace Blackwell PCB 上。同時,全球各地的工廠正在準備額外的組件。

來自 Cooler Master、ABC、Auras 和 Delta 的客製化液冷銅塊,使晶片保持在最佳溫度。在另一家 Foxconn 工廠,ConnectX7 SuperNIC 被製造出來以實現橫向擴展通訊,而 BlueField 3DPU 則用於卸載和加速網路、儲存和安全任務。所有這些部件匯集在一起,被小心地整合到 GB200 運算托盤中。

MVLink 是 Nvidia 發明的突破性高速鏈路,用於連接多個 GPU 並擴展成一個巨大的虛擬 GPU。MVLink 交換器托盤由 MVLink 交換器晶片構成,提供每秒 14.4 TB 的全對全頻寬。MVLink 主幹形成一個客製化的盲插背板,整合了 5,000 條銅纜,提供每秒 130 TB 的全對全頻寬。

這將所有 72 個 Blackwell 或 144 個 GPU 晶粒連接成一個來自世界各地的巨型 GPU。零件從 Foxconn、Wistron、Quanta、Dell、Asus、Gigabyte、HPE、Super Micro 和其他合作夥伴運抵,由熟練的技術人員組裝成一個機架規模的 AI 超級電腦,總共包含 120 萬個組件、2 公尺的銅纜、130 兆個電晶體,重達 1,800 公斤。

從第一個蝕刻在晶圓上的電晶體,到最後一個固定 Blackwell 機架的螺栓,每一步都承載著我們合作夥伴的奉獻、精確和工藝。Blackwell 不僅僅是一個技術奇蹟。它是台灣科技生態系統奇蹟的證明。我們為我們共同取得的成就感到無比自豪。謝謝你,台灣。

謝謝。謝謝。那真是太不可思議了,對吧?但那是你們。那是你們。謝謝。

為台灣打造AI基礎設施

嗯,台灣不僅為世界建造超級電腦。今天我非常高興地宣布,我們也正在為台灣打造 AI。因此,今天我們宣布 Foxconn、台灣、台灣政府、Nvidia、TSMC,我們將在這裡為台灣的 AI 基礎設施和 AI 生態系統建造第一台巨型 AI 超級電腦。謝謝。

現場有誰需要 AI 電腦嗎?有 AI 研究人員在場嗎?每一位學生、每一位研究人員、每一位科學家、每一家新創公司、每一家大型成熟企業。TSMC 本身已經進行了大量的 AI 和科學研究。因此,Foxconn 在機器人領域也做了大量的工作。

我知道在座還有許多其他公司。我稍後會提到你們,你們正在進行機器人研究和 AI 研究。因此,在台灣擁有世界一流的 AI 基礎設施非常重要。所有這一切都是為了讓我們能夠製造一個非常大的晶片。

而 MVLink 和 Blackwell 這一代讓我們得以創造這些令人難以置信的系統。這是來自 Pegatron 和 QCT 以及 Wishron 和 WeWin 的產品。這是來自 Foxconn 和 Gigabyte 以及 ASUS 的產品。你可以看到它的正面和背面。它的全部目標,它的全部目標就是將這些 Blackwell 晶片,你可以看到它們有多大,變成一個巨大的晶片。

NVIDIA MVLink Fusion:開放的AI基礎設施

當然,能夠做到這一點是由 MVLink 促成的,但這低估了系統架構的複雜性、將所有一切連接在一起的豐富軟體生態系統、共同打造這個架構的 150 家公司的整個生態系統,以及在技術、軟體和產業中的整個生態系統,這都是三年努力的成果。

這是一項龐大的工業投資,現在我們希望讓任何想建造資料中心的人都能做到。它可以是一大堆 NVIDIA GB200 或 300,以及來自 Nvidia 的加速運算系統。它也可以是其他人的。所以今天我們要宣布一些非常特別的東西。

我們宣布推出 NVIDIA MVLink Fusion。MVLink Fusion 讓您可以建構半客製化的 AI 基礎設施,而不僅僅是半客製化晶片,因為那些是過去的美好時光。您想要建構 AI 基礎設施,而每個人的 AI 基礎設施可能都有些不同。你們有些人可能有很多 CPU,有些人可能有很多 Nvidia GPU,有些人可能是某人的半客製化 ASIC。

而那些系統建造起來極其困難,它們都缺少一個令人難以置信的要素。這個令人難以置信的要素叫做 MVLink。MVLink 讓你可以擴展這些半客製化系統,並建造真正強大的電腦。所以今天我們宣布推出 MVLink Fusion。

MVLink Fusion 的運作方式大致如下。這是 Nvidia 平台,100% Nvidia。你有 Nvidia CPU、Nvidia GPU、MVLink 交換器、來自 Nvidia 的網路,稱為 Spectrum X 或 Infiniband、Nyx、網路互連、交換器以及整個系統、整個基礎設施,端到端建構。

當然,如果你喜歡,你可以混合搭配,而我們今天讓你在運算層級也能混合搭配。這就是你會使用你的客製化 ASIC 所做的事情。我們有很棒的合作夥伴,我稍後會宣布,他們正在與我們合作,整合你特殊的 TPU 或你特殊的 ASIC,你特殊的加速器。

而且它不一定只是個 Transformer 加速器。它可以是任何你想整合到大型擴展系統中的加速器。我們創建了一個 MVLink 晶片。它基本上是一個緊鄰你晶片的交換器。我們將提供 IP 供你整合到你的半客製化 ASIC 中。一旦你這樣做了,它就能完美地安裝到我提到的運算板中,並融入我向你展示的這個 AI 超級電腦生態系統。

也許你想要的是使用你自己的 CPU。你已經開發自己的 CPU 一段時間了,也許你的 CPU 已經建立了一個非常龐大的生態系統,而你希望將 Nvidia 整合到你的生態系統中。現在我們讓你能夠做到這一點。你可以透過打造你的客製化 CPU 來實現。

我們為您提供我們的 MVLink 晶片對晶片介面,整合到您的 ASIC 中。我們將其與 MVLink 小晶片連接起來。現在它直接連接並緊鄰 Blackwell 晶片和我們的下一代 Ruben 晶片。同樣地,它完美地融入了這個生態系統。這個令人難以置信的工作成果現在變得靈活且開放,供大家整合。

所以你的 AI 基礎設施可以有一些 Nvidia 的產品,很多你自己的產品,很多你自己的產品,你知道的,還有很多 CPU,很多 ASIC,也許還有很多 Nvidia GPU。無論如何,你都可以受益於使用 MVLink 基礎設施和 MVLink 生態系統,它與 Spectrum X 完美連接,所有這些你都知道是工業級的,並且受益於一個龐大的工業合作夥伴生態系統,他們已經使這一切成為可能。所以這就是 MVLink Fusion。

無論您是否完全向我們購買,那都太棒了。沒有什麼比您從 Nvidia 購買所有東西更讓我高興的了。我只是想讓你們知道。但如果您只從 Nvidia 購買一些東西,也會讓我非常高興。所以我們有一些很棒的合作夥伴。我們有一些很棒的合作夥伴。LCHIP、Astera Labs、Marvell 和我們的一個偉大合作夥伴 MediaTek 將與我們合作,與 ASIC 或半客製化客戶、希望建造這些東西的超大規模資料中心,或希望建造這些東西的 CPU 供應商合作。

他們將成為他們的半客製化供應商。我們還有 Fujitsu 和 Qualcomm,他們正在製造帶有 MVLink 的半客製化 CPU,以整合到我們的生態系統中,還有 Cadence 和 Synopsis。我們與他們合作,將其整合到你們所有的晶片中。所以這個生態系統令人難以置信。

但這僅突顯了 MVLink Fusion 生態系統。一旦你與他們合作,你就能立即整合到整個更大的 Nvidia 生態系統中,使你能夠擴展到這些 AI 超級電腦。

新產品類別:DGX Spark 與 DGX Station

現在,讓我來談談一些新的產品類別。如你們所知,我已經展示了幾種不同的電腦。

然而,為了服務絕大多數的世人,仍然缺少一些電腦。所以,我將談論它們。但在我這樣做之前,我想向大家更新一下,事實上,我們稱之為 DGX Spark 的這款新電腦已經全面投產。DGX Spark 很快就會上市,可能在幾週內。

我們有許多優秀的合作夥伴與我們合作。Dell、HPI、Asus、MSI、Gigabyte、Lenovo,這些都是與我們合作的令人難以置信的夥伴。這就是 DGX Spark。這實際上是一個量產單位。這是我們的版本。這是我們的版本。然而,我們的合作夥伴正在打造許多不同版本。 這是專為 AI 原生開發者設計的。如果你是開發者、學生或研究人員,而且你不想一直開啟雲端、準備好它,然後在你完成後再清理它,好的,但你只想擁有自己的,基本上是你自己的 AI 雲端,就在你旁邊,而且它永遠開啟,永遠等著你。

它讓你可以進行原型製作、早期開發。這就是令人驚奇的地方。這是 DGX Spark。它有 1 petaflop 的運算能力和 128 GB 的記憶體。2016 年我交付 DGX1 時,這只是面板。我舉不起整台電腦。它有 300 磅重。這是 DGX1。它有 1 petaflop 的運算能力和 128 GB 的記憶體。

當然,這是 128 GB 的 HBM 記憶體。而這是 128 GB 的 LPDDR5X。效能其實相當接近。但最重要的是,你可以在這上面做的工作,和你在這裡可以做的工作是一樣的。這在短短大約十年的時間裡,是一項令人難以置信的成就。好的。

所以這是 DGX Spark,專為任何想要擁有自己 AI 超級電腦的人設計。而且它的價格……我會讓所有合作夥伴自行定價,但有一點可以肯定,每個人都可以在聖誕節前擁有一台。

好的,我還有另一台電腦想秀給你看。如果那還不夠,而你仍然想擁有你個人的……謝謝你,Janine。

這位是 Janine Paul,各位先生女士。如果那台對你來說不夠大,這裡還有一台。這也是一台桌邊型電腦。Dell、HPI、Asus、Gigabyte、MSI、Lenovo 也會提供。它將可從 Box、Lambda 等優秀的工作站公司購得。

這將是你個人的 DGX 超級電腦。這台電腦是你從牆壁插座所能獲得的最高效能。你可以把它放在你的廚房,但僅僅是勉強可以。如果你把它放在廚房,然後有人使用微波爐,我想那就達到極限了。所以這就是極限。

這是你能從牆壁插座獲得的極限。這是一台 DGX 工作站。它的程式設計模型和我之前展示的巨型系統是相同的。這才是最令人驚奇的地方。單一架構,單一架構。它擁有足夠的容量和效能來運行一個一兆參數的 AI 模型。

記住 Llama 是 Llama 70B。一個一兆參數的模型將會在這台機器上運行得非常出色。好的,那就是 DGX Station。

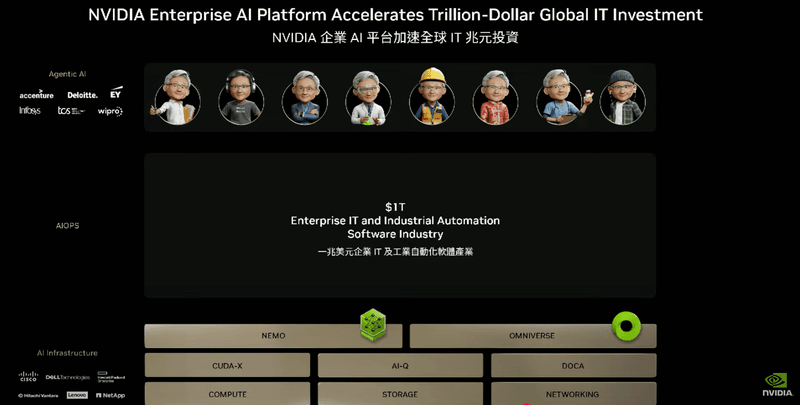

為企業IT打造AI:AI原生電腦

所以現在讓我們來談談,記住這些系統……謝謝你,Jenny。這些系統,這些系統是 AI 原生的。它們是 AI 原生電腦。它們是為這個新一代軟體打造的電腦。

它不必與 x86 相容。它不必運行傳統的 IT 軟體。它不必運行虛擬機監視器(hypervisors)。它不必運行所有……它不必運行 Windows。這些電腦是為現代 AI 原生應用程式設計的。當然,這些 AI 應用程式可以是 API,可以被傳統和經典應用程式調用。

但為了將 AI 引入一個新世界,而這個新世界就是企業 IT,我們必須回歸我們的根源,我們必須革新運算,並將 AI 引入傳統的企業運算。

現在,我們所知的企業運算實際上分為三層。它不僅僅是運算層。

它是運算、儲存和網路。始終是運算、儲存和網路。正如 AI 改變了一切一樣,AI 也必定改變了企業 IT 的運算、儲存和網路。嗯,底層必須徹底革新,我們正在進行中。

我將向你們展示一些新產品,為我們開啟企業 IT 的大門。它必須與傳統 IT 產業合作,並且必須增加一項新功能,而企業的新功能就是代理式 AI(agentic AI)。基本上是數位行銷活動經理、數位研究員、數位軟體工程師、數位客服、數位晶片設計師、數位供應鏈經理,所有我們過去所做工作的數位版本、AI 版本。

正如我之前提到的,代理式 AI 具有推理、使用工具、與其他 AI 協作的能力。因此,在很多方面,它們是數位工作者。它們是數位員工。世界面臨勞動力短缺。到 2030 年,我們將短缺約 3000 萬到 5000 萬勞動力。這實際上限制了世界的增長能力。

所以現在我們有了這些可以和我們一起工作的數位代理人。NVIDIA 100% 的軟體工程師現在都有數位代理人與他們一起工作,協助他們開發更好的程式碼,並提高生產力。因此,未來,你將擁有這一層。這是我們的願景。

你將會有一層代理式 AI,AI 代理。那麼世界會發生什麼事?企業會發生什麼事?過去我們有人力資源部門管理人類員工,未來 IT 部門將會成為數位員工的人力資源部門。因此,我們必須為現今的 IT 產業、現今的 IT 工作者創造必要的工具,讓他們能夠管理、改進、評估在他們公司內部工作的一整群 AI 代理。

這就是我們想要建立的願景。但首先,我們必須革新運算。記住我說過的,企業 IT 運行在 x86 上。它運行傳統軟體,例如 VMware 或 IBM Red Hat 或 Nutanix 的虛擬機監視器。它運行一大堆經典應用程式,我們需要有能夠做同樣事情的電腦,同時增加這個新功能,同時增加這個名為代理 AI 的新功能。

所以讓我們看看。

RTX Pro企業級伺服器

好的,這是全新的 RTX Pro。RTX Pro 企業版和 Omniverse 伺服器。這台伺服器可以運行所有東西。它當然有 x86。它可以運行所有經典的虛擬機監視器。它在那些虛擬機監視器中運行 Kubernetes。所以你的 IT 部門管理網路和管理你的叢集和協調工作負載的方式完全相同。它甚至能夠串流 Citrix 和其他虛擬桌面到你的個人電腦。現今世界上運行的所有東西都應該在這裡運行。Omniverse 在這裡完美運行。但除此之外,除此之外,這是企業 AI 代理的電腦。

那些 AI 代理可能只有文字。那些 AI 代理也可能是電腦繪圖,一些小 TJ,你知道的,來找你,一些玩具 Jensen 來見你,你知道的,幫助你工作。所以那些 AI 代理可以是文字形式,可以是繪圖形式,可以是影片形式。所有這些工作負載都在這個系統上運作。

無論模式為何,我們所知的世界上每一個模型,我們所知的每一個應用程式都應該在這上面運行。事實上,即使是 Crisis 也能在這裡運行。好的,所以任何 GeForce 玩家,房間裡沒有 GeForce 玩家。好的,是什麼連接這八個 GPU?Blackwell,新的 Blackwell RTX,RTX Pro 6000s,是這個新的主機板。

這個新的主機板實際上是一個交換式網路。CX8 是一個新的晶片類別。它首先是交換器,其次才是網路晶片。它也是世界上最先進的網路晶片。CX8 現已量產。在 CX8 中,你插入 GPU。CX8 在後面。PCI Express 連接在這裡。

CX8 在它們之間進行通訊,網路頻寬高達每秒 800 gigabits,令人難以置信。這是插入這裡的收發器。所以這些 GPU 中的每一個都有自己的網路介面。所有 GPU 現在都在東西向流量上與所有其他 GPU 通訊。效能令人難以置信。

現在令人驚訝的部分是這個。它有多麼不可思議。所以這是,這是 RTX Pro。這是效能,我在 GTC 上向大家展示了如何在 AI 工廠的世界中思考效能。思考的方式是吞吐量。這是每秒詞元數(tokens per second),也就是 y 軸。你的工廠產出越多,你產生的詞元就越多。

好的?所以吞吐量是衡量每秒的詞元數。然而,每個 AI 模型都不相同,有些 AI 模型需要更多的推理,所以你需要那些 AI 模型,你需要每個使用者的效能非常高。所以每個使用者每秒的詞元數必須很高。這就是工廠的問題。

工廠要嘛喜歡高吞吐量,要嘛喜歡低延遲,但它不喜歡兩者兼具。所以挑戰是如何創建一個作業系統,讓我們能夠擁有高吞吐量,即 y 軸,同時擁有非常低的延遲,即 y 軸,互動性,每個使用者每秒的詞元數。

所以這張圖表告訴你一些關於電腦整體效能,工廠整體運算效能的事情。看看所有那些不同的顏色。它反映了,它代表了你必須配置我們所有 GPU 以達到效能的不同方式。有時你需要管線平行處理,有時你需要專家平行處理,有時你需要批次處理,有時你需要做推測性解碼,有時你不需要。

因此,所有這些不同類型的演算法都必須根據工作負載分別和不同地應用。而該曲線的外部區域,即總體區域,代表了您工廠的能力。好的。因此,請注意,Hopper 是我們的,這是世界上最著名的電腦。Hopper H100。

HGX 價值 225,000 美元,Hopper 在那裡。而你剛才看到的 Black Wall 伺服器,企業伺服器,其效能是它的 1.7 倍。但這很驚人。這是 Llama 70B。這是 DeepSeek R1。DeepSeek R1 是四倍。現在,原因當然是 DeepSeek R1 已經過優化,而 DeepSeek R1 真的是對世界 AI 產業的一份禮物。

電腦科學突破的數量確實相當可觀,並且為美國乃至全球各地的研究人員開啟了許多偉大的研究。無論我走到哪裡,R1 都在人們如何思考 AI、如何思考推論以及如何思考推理 AI 方面產生了真正的影響。他們對產業和世界做出了巨大貢獻。

所以這是 DeepSeek R1,效能是最先進 H100 的四倍,這讓大家有個概念。好的?所以如果你正在建立企業級 AI,我們現在為你提供了一款很棒的伺服器。我們現在為你提供了一個很棒的系統。這是一台你可以運行任何東西的電腦。這是一台效能令人難以置信的電腦,而且,你知道,無論是 x86 還是 AI,它都能運行。好的,它將會,我們的 RTX Pro 伺服器正在與我們業界所有合作夥伴一起量產。

這可能是我們有史以來推向市場的系統中,市場進入規模最大的一次。所以,非常感謝。

為AI革新儲存平台

運算平台不同。儲存平台也不同。原因在於人類查詢的是像 SQL 這樣的結構化資料庫。人們查詢的是像 SQL 這樣的結構化資料庫。但 AI 想要查詢的是非結構化資料。它們想要語義。

它們想要意義。所以我們必須創造一種新型的儲存平台。這就是 NVIDIA AI 資料平台,就像 SQL 伺服器、SQL 軟體和你合作的儲存供應商提供的檔案儲存軟體一樣,儲存也伴隨著一層非常複雜的軟體。

如你所知,大多數儲存公司主要是一家軟體公司。那層軟體非常複雜。因此,在一種新型儲存系統之上,將會出現一種我們稱之為 IQ、Nvidia AIQ 或 IQ 的新型查詢系統。它確實是最新技術。它非常棒。而且我們基本上與儲存行業的每個人合作。

您未來的儲存不再是 CPU 位於一排儲存設備之上。它將是 GPU 位於一排儲存設備之上。原因在於您需要系統嵌入、在非結構化資料、原始資料中找到意義。您必須建立索引、進行搜尋並進行排序。

所以這個過程的計算量非常大。因此未來大多數儲存伺服器前端都會有一個 GPU 運算節點。它基於我們創建的模型。我即將展示的幾乎所有東西都始於優秀的 AI 模型。我們創建 AI 模型。我們投入大量的精力和技術來對開放的 AI 模型進行後訓練。

我們用對您完全透明的資料來訓練這些 AI 模型。這些資料是安全可靠的,而且完全可以用來訓練,我們會將清單提供給您查看,所以一切都是完全透明的。我們將資料提供給您。

我們對模型進行後訓練,而我們後訓練模型的效能確實令人難以置信。它現在是可下載的開源推理模型。Llama Neotron 推理模型是世界上最好的。它的下載量非常大。而且我們還用一大堆其他 AI 模型圍繞著它,這樣你就可以做所謂的 IQ,也就是檢索部分。

它比現有的快 15 倍。查詢結果好 50%。所以這些模型都提供給你。它的藍圖,IQ 藍圖是開源的,我們與儲存產業合作,將這些模型整合到他們的儲存堆疊和 AI 平台中。這是 Vast。

這就是它的樣子。我不會深入探討。我只是想讓你們感受一下整合到他們平台中的 AI 模型的質感。讓我們看看 Vast 做了什麼。代理式 AI 改變了企業使用資料做決策的方式。僅僅三天,VAS 就使用 NVIDIA IQ 藍圖及其加速 AI 資料平台建立了一個銷售研究 AI 代理。

該平台使用 Nemo Retriever,持續提取、嵌入和索引資料,以實現快速語義搜尋。首先,代理程式草擬大綱,然後利用 CRM 系統、多模態知識庫和內部工具。最後,它使用 Llama Neimatron 將該大綱轉化為逐步的銷售計畫。過去需要數天的銷售規劃,現在從一個 AI 提示開始,幾分鐘內就能完成計畫。

透過 Vast 的加速 AI 資料平台,組織可以為每位員工創建專門的代理程式。

好的,那就是 Vast。Dell 有一個很棒的 AI 平台,是世界領先的儲存供應商之一。Hitachi 有一個很棒的 AI 平台,AI 資料平台。IBM 正在用 NVIDIA Nemo 打造一個 AI 資料平台。NetApp 正在打造一個網路 AI 平台。

如你所見,所有這些都對你開放。如果你正在建構一個前端帶有語義查詢 AI 的 AI 平台,Nvidia Nemo 是世界上最好的。

AI Ops:管理企業AI的新軟體層

好的。所以這讓你們現在擁有了企業級運算和企業級儲存。下一部分是一個名為 AI Ops 的新軟體層。就像供應鏈有他們的營運部門,人力資源有他們的營運部門一樣,未來 IT 將會有 AI Ops,他們將整理資料。

他們會微調模型。他們會評估模型、設定模型的防護機制、保護模型,我們擁有一大堆必要的函式庫和模型,以便整合到 AI Ops 生態系統中。我們有很棒的合作夥伴來幫助我們做到這一點,將其推向市場。CrowdStrike 正在與我們合作。

DataIQ 正在與我們合作。Data Robots 正在與我們合作。你可以看到這些都是 AI 操作,為企業中的代理式 AI 創建微調模型和部署模型,你可以看到 NVIDIA 的函式庫和模型遍佈其中。所以 Data Robots 在這裡,這是 Data Stacks,這是 Elastic,我想我聽說過他們被下載了 4000 億次。

這是 Newonix。這是 Red Hat。這是台灣的 Trend Micro。我想我早些時候看到 Eva 了。好的。嗨,Eva。好的。有些偏見。好的。所以就是這樣。這就是我們將如何為世界企業 IT 帶來能力,將 AI 添加到你所做的一切中。

你不會從企業 IT 組織中移除所有東西,因為公司必須運作。但我們可以將 AI 加入其中。現在我們有了企業級的系統,以及令人難以置信的生態系統合作夥伴。我想我早些時候看到了 Jeff。那是 Jeff Clark,偉大的 Jeff Clark,他來台灣的時間和我一樣長,並且長期以來一直是你們所有人的合作夥伴。

所以那是 Jeff Clark。然後,我們的生態系統合作夥伴,Dell 和其他公司,將把這個平台,這些平台,帶給全世界的企業 IT。

機器人技術:從虛擬學習到實體應用

好的,我們來談談機器人。所以代理式 AI、AI 代理,有很多不同的說法,代理程式基本上就是數位機器人,原因在於機器人感知、理解和規劃,而這基本上就是代理程式所做的事情。

但我們也想打造實體機器人,而這些實體機器人首先需要具備學習成為機器人的能力。學習成為機器人的能力無法在實體世界中有效率地完成。你必須創造一個虛擬世界,讓機器人可以在其中學習如何成為一個好機器人。那個虛擬世界必須遵守物理定律。

大多數物理引擎無法忠實處理剛體和軟體的模擬。因此,我們與 DeepMind、Google DeepMind 和 Disney Research 合作開發了 Newton,這是世界上最先進的物理引擎。它將於七月開源。它的功能令人難以置信。

它完全由 GPU 加速。它是可微分的,所以你可以從經驗中學習。它的保真度極高。它是超即時的,所以我們可以使用那個新引擎,而且它已經整合到 Mujoko 中。它已經整合到 Nvidia 的 Isaac Sim 中。所以無論你使用哪種模擬環境和框架。

因此,我們就能讓這些機器人活起來。女王。誰不想要那個?我想要那個。你能想像一個或幾個那樣的小東西在家裡跑來跑去追你的狗,把牠們逼瘋嗎?所以,你看到發生了什麼嗎?

那不是動畫。那是一個模擬。他在沙地裡、泥土裡滑動。所有的一切都是模擬的。機器人的軟體在模擬中運行。所以它不是動畫,而是模擬。因此,未來,我們將把我們訓練的 AI 模型放入模擬中的那個機器人,讓它學習如何成為一個偉大的機器人。

嗯,我們正在進行幾項工作來協助機器人產業。現在,你們知道我們從事自動駕駛系統已經有一段時間了。我們的自動駕駛汽車基本上有三個系統。一個是創建 AI 模型的系統,那就是 GB200、GB300。它將用於訓練 AI 模型。

然後你有 Omniverse 用於模擬 AI 模型。當你完成那個 AI 模型後,你把那個模型,那個 AI,放進自動駕駛汽車裡。好的。今年我們將在全球部署 Mercedes,我們的自動駕駛汽車堆疊,端到端堆疊。但我們創造了所有這些,以及我們進入市場的方式與我們在其他地方的工作方式完全相同。

我們創建整個堆疊。我們開放整個堆疊,而對於我們的合作夥伴,他們可以使用任何他們想使用的東西。他們可以使用我們的電腦而不使用我們的函式庫。他們可以使用我們的電腦、我們的函式庫,以及我們的執行時期。你想使用多少,取決於你,因為有許多不同的工程團隊、不同的工程風格和不同的工程能力。

我們希望確保我們提供的技術能夠讓每個人盡可能輕鬆地整合 NVs 的技術。你知道,就像我說的,如果你從我這裡買所有東西,我會很高興,但請至少從我這裡買一些東西。非常實際。所以我們在機器人系統方面做的完全一樣,就像汽車一樣。

所以這是我們的 Isaac Groot 平台。模擬與 Omniverse 完全相同。運算訓練系統也相同。當你完成模型後,你將其放入這個 Isaac Groot 平台內。而 Isaac Groot 平台始於一款名為 Jetson Thor 的全新電腦。這款產品剛開始生產。

它是一個令人難以置信的處理器。基本上是一個機器人處理器,用於自動駕駛汽車,也用於人形或機器人系統。在其之上是一個我們稱為 Isaac Nvidia Isaac 的作業系統。Nvidia Isaac 作業系統是執行時期。它負責所有神經網路處理、感測器處理管線等等,並提供驅動結果,然後在其之上是我們與一個瘋狂的、了不起的機器人團隊預先訓練的模型,他們正在預先訓練這些模型,以及所有必要的工具。

在創造這個的過程中,我們提供了所有必要的東西,包括模型。所以今天我們宣布 Isaac Groot N1.5 現在已經開源,並且向全世界開放。它已經被下載了 6000 次,社群的受歡迎程度、按讚數和讚賞程度都令人難以置信。

所以這是在創造模型。我們也公開了我們創造模型的方式。機器人學最大的挑戰,嗯,AI 整體最大的挑戰是你的資料策略是什麼,而你的資料策略必須是,那裡有大量的研究和大量的技術投入。以機器人學為例,人類示範,就像我們向我們的孩子示範,或者教練向運動員示範一樣,你使用遠端操作向機器人示範如何執行任務,而機器人可以從那個示範是因為 AI 可以泛化,我們有泛化技術。你可以從那一個示範中泛化出其他技巧。好的。那麼如果你想教這個機器人一大堆技能呢?你需要多少不同的遙控操作人員?嗯,結果是很多。

所以我們決定做的是,你使用 AI 來放大人類示範系統。所以這基本上是從真實到真實,並使用 AI 來幫助我們擴展、放大在人類示範期間收集到的資料量,以訓練 AI 模型。讓我們看看。

Groot Dreams:用AI擴展機器人技能學習

通用型機器人時代已經來臨,這得益於機電整合、物理 AI 和嵌入式運算的突破。

時機正好,因為勞動力短缺限制了全球工業的增長。機器人製造商面臨的一個主要挑戰是缺乏大規模的真實和合成數據來訓練模型。人類示範不可擴展,受限於一天中的小時數。開發者可以使用 NVIDIA Cosmos 物理 AI 世界基礎模型來擴增數據。

Group Dreams 是一個建立在 Cosmos 之上的藍圖,用於大規模合成軌跡資料生成,這是一個真實到真實的資料工作流程。首先,開發人員使用在單一環境中透過遙控操作記錄的單一任務的人類示範來微調 Cosmos。然後,他們用圖像和新指令提示模型,以生成夢境或未來的世界狀態。 Cosmos 是一個生成模型,因此開發者可以使用新的動作詞彙來提示,而無需擷取新的遙控操作資料。一旦產生大量資料,Cosmos 會推理並評估每個夢境的品質,選擇最佳者進行訓練。但這些夢境仍然只是像素。機器人從動作中學習。Groot Dreams 藍圖從 2D 夢境影片中產生 3D 動作軌跡。

然後用這個來訓練機器人模型。Group Dreams 讓機器人能以最少的人工擷取學習各種新動作。所以,一個小型的人類示範團隊現在可以完成數千人的工作。Groot Dreams 讓開發者更接近解決機器人資料挑戰。那不是很棒嗎?

所以為了讓機器人技術發生,你需要 AI。

但為了教導 AI,你需要 AI。所以這確實是代理人時代的偉大之處,我們需要大量的合成資料生成、機器人技術、大量的合成資料生成和技能學習,也就是微調,這涉及大量的強化學習和巨大的運算量。

所以這是一個時代,一個完整的時代,這些 AI 的訓練、這些 AI 的開發以及 AI 的運行都需要巨大的運算量。嗯,正如我之前提到的,世界嚴重缺乏勞動力。而人形機器人之所以如此重要,是因為它是唯一幾乎可以在任何棕地(brownfield)部署的機器人形式。

它不必是綠地(green field)。它可以融入我們創造的世界。它可以完成我們為自己設定的任務。我們為自己設計了這個世界,現在我們可以創造一個能融入那個世界來幫助我們的機器人。現在,人形機器人的驚人之處不僅僅在於如果它能成功運作,它就能非常多功能。

它很可能是唯一可能成功的機器人,原因在於技術需要規模。我們目前擁有的大多數機器人系統的產量都太低。而那些低產量的系統永遠無法達到技術規模,讓飛輪轉得夠遠夠快,以至於我們願意投入足夠的技術來改進它。

但人形機器人,它很可能成為下一個數兆美元的產業。技術創新速度極快,運算和資料中心的消耗量也極大。但這是需要三台電腦的應用之一。一台電腦是 AI 用於學習。

一台電腦是一個模擬引擎,AI 可以在虛擬環境中學習如何成為一個機器人。然後還有它的部署。所有會動的東西都將是機器人。當我們把這些機器人放進工廠時,記住工廠本身也是機器人化的。今天的工廠極其複雜。

這是 Delta 的生產線,他們正在為機器人化的未來做準備。它已經是機器人化和軟體定義的,未來將有機器人在其中工作。為了創造和設計能夠在工廠中作為一個團隊、一個整體運作的機器人,而工廠本身也是機器人化的,我們必須給它 Omniverse 來學習如何協同工作。

那個數位分身,你現在有了機器人的數位分身,你有了所有設備的數位分身,你將擁有工廠的數位分身。那些巢狀的數位分身將成為 Omniverse 能夠做到的一部分。這是 Delta 的數位分身。這是 WiiWin 的數位分身。

現在,當你看著這個的時候,如果你不仔細看,你會以為那其實是照片。這些全都是數位分身。它們全都是模擬。它們只是看起來很美。影像看起來很美,但它們全都是數位分身。這是 Pegatron 的數位分身。這是 Foxconn 的數位分身。

這是 Gigabytes 的數位分身。這是 Quantis 的。這是 Wistrons 的。TSMC 正在為他們的下一座晶圓廠打造數位分身。就在我們說話的同時,全球有價值五兆美元的工廠正在規劃中。未來三年,價值五兆美元的新工廠,因為世界正在重塑,因為全球範圍內的再工業化。

新工廠正在各地興建。這對我們來說是一個巨大的機會,可以確保他們建造得好、符合成本效益且準時。因此,將所有東西都放入數位分身確實是一個很好的第一步,並為機器人化的未來做好準備。事實上,建造那五兆美元並不包括我們正在建造的一種新型工廠。

即使是我們自己的工廠,我們也將其置於數位分身中。這是 Nvidia AI 工廠的數位分身。高雄是數位分身。他們將高雄打造成數位分身。已經有數十萬棟建築物、數百萬英里的道路。所以,是的,高雄是數位分身。讓我們看看所有這些。

台灣引領軟體定義製造與數位分身

台灣正在引領軟體定義製造。TSMC、Foxconn、Wistron、Pegatron、Delta Electronics、Quanta、WiiWin 和 Gigabyte 正在 Nvidia Omniverse 上為製造過程的每一步開發數位分身。TSMC 與 MEAI 合作,從 2D CAD 生成整個晶圓廠的 3D 佈局,並在 co-op 上開發 AI 工具,可以模擬和優化跨越多個樓層的複雜管道系統,節省數月時間。

Quanta、Wistron 和 Pegatron 在實體建造前,先虛擬規劃新廠房和生產線,透過減少停機時間節省數百萬美元的成本。Pegatron 模擬錫膏印刷,減少生產瑕疵。Quanta 使用 Siemens Teamcenter X 搭配 Omniverse 來分析和規劃多步驟流程。

Foxconn、Wistron 和 Quanta 使用 Cadence Reality 數位分身模擬測試資料中心的電力和冷卻效率,並開發具備物理 AI 功能的機器人。每家公司都將其數位分身作為機器人健身房,用於開發、訓練、測試和模擬機器人,無論是機械手臂、自主移動機器人(AMR)、人形機器人還是視覺 AI 代理,在它們執行任務或作為多樣化團隊協同工作時。

當透過物聯網(IoT)與實體分身連接時,每個數位分身都變成一個即時互動的儀表板。Pegatron 使用 NVIDIA Metropolis 建構 AI 代理,協助員工學習複雜技術。台灣甚至將數位分身帶入其城市。Linker Vision 和高雄市政府使用數位分身模擬不可預測情境的影響,並建構代理程式監控城市攝影機串流,向急救人員發送即時警報。

工業 AI 時代已經來臨。由台灣的科技領導者開創。由 Omniverse 提供動力。

台灣的機遇與NVIDIA Constellation的宣布

我整個主題演講都是你們的成果。真是太棒了。嗯,理所當然地,理所當然地,台灣處於最先進產業的中心,是 AI 和機器人技術即將誕生的震央。理所當然地,這對台灣來說是一個非凡的機會。

這裡也是世界上最大的電子製造區。因此,AI 和機器人技術將改變我們所做的一切,這是理所當然的。因此,這確實是非同尋常的,在我們歷史上第一次,你們所做的工作不僅革新了每個行業,現在它將回過頭來革新你們自己的行業。

一開始我說 GeForce 將 AI 帶給了世界,然後 AI 回來改變了 GeForce。你們將 AI 帶給了世界。AI 現在將回來改變你們所做的一切。與大家合作非常愉快。謝謝。我有一個新產品。我今天已經宣布了好幾個產品,但我還有一個新產品要宣布。

我有一個新產品要宣布。我們在太空碼頭建造已有一段時間了,嗯,我想是時候揭曉我們有史以來建造的最大的產品之一了。它停在外面等著我們。讓我們看看情況如何。

NVIDIA Constellation。NVIDIA Constellation。嗯,如你們所知,我們一直在成長,我們與你們所有的合作夥伴關係也一直在成長。我們在台灣的工程師數量一直在增加。因此,我們正在超越目前辦公室的極限。所以我將為他們建造一個全新的 NVIDIA 台灣辦公室,它叫做 NVIDIA Constellation。

我們也一直在挑選地點。我們一直在挑選地點,所有市長和所有不同城市都對我們非常友善,我想我們達成了一些不錯的交易。我不確定。看起來相當昂貴,但黃金地段就是黃金地段。所以今天,今天我非常高興地宣布,NVIDIA Constellation 將設在北投士林。

我們已經協商了從目前該租約的現有所有者手中轉讓租約。然而,我知道市長要批准該租約,他想知道台北市民是否贊成我們在這裡建造一個大型、美麗的 Nvidia Constellation。你是否贊成?他還要求你打電話給他,所以我相信你知道他的電話號碼。大家馬上打電話給他。 告訴他你覺得這是個好主意。所以這將是 Nvidia Constellation。我們將建造它。我們將盡快開始建造。我們需要辦公空間。Nvidia Constellation 北投士林。非常令人興奮。

結語與感謝

好的。嗯,我想感謝大家。我想感謝大家多年來的合作夥伴關係。

我們正處於一個千載難逢的機會。毫不誇張地說,我們面前的機會是非凡的。在我們共同經歷的所有時光中,這是第一次,我們不僅在創造下一代 IT,我們已經這樣做過好幾次了,從個人電腦到網際網路、到雲端、到行動雲端。

我們已經做過好幾次了。但這一次,我們不僅在創造下一代 IT,我們實際上在創造一個全新的產業。這個全新的產業將為我們帶來巨大的未來機遇。我期待與大家合作,共同打造 AI 工廠、企業代理人、機器人,所有這些了不起的合作夥伴,與我們一起圍繞著一個架構建立生態系統。 所以,我要感謝大家今天的蒞臨。祝大家 Computex 順利。謝謝。謝謝你們來。謝謝。